Llama 3 er Metas siste store språkmodell. Du kan bruke den til ulike formål, for eksempel å løse spørsmålene dine, få hjelp med skolelekser og prosjekter osv. Ved å distribuere Llama 3 på Windows 11-maskinen din lokalt, kan du bruke den når som helst, selv uten tilgang til internett. Denne artikkelen viser deg hvordan installere Llama 3 på en Windows 11 PC .

Hvordan installere Llama 3 på en Windows 11 PC

Å installere Llama 3 på en Windows 11 PC gjennom Python krever tekniske ferdigheter og kunnskap. Noen alternative metoder lar deg imidlertid distribuere Llama 3 lokalt på din Windows 11-maskin. Jeg vil vise deg disse metodene.

For å installere Llama 3 på din Windows 11 PC, må du utføre noen kommandoer i ledeteksten. Dette vil imidlertid bare tillate deg å bruke kommandolinjeversjonen. Du må ta ytterligere skritt hvis du vil bruke web-UI. Jeg vil vise deg begge disse metodene.

Distribuer Llama 3 på Windows 11 PC via CMD

For å distribuere Llama 3 på din Windows 11 PC, må du installere Ollama på din Windows-maskin. Fremgangsmåten for det samme er som følger:

- Besøk Ollamas offisielle nettsted .

- Klikk på Last ned og velg deretter Windows .

- Klikk nå på Last ned for Windows for å lagre exe-filen på din PC.

- Kjør exe-filen for å installere Ollama på maskinen din.

Når Ollama er installert på enheten din, start datamaskinen på nytt. Den skal kjøres i bakgrunnen. Du kan se det i systemstatusfeltet. Klikk nå på alternativet Modeller på Ollama-nettstedet. Du vil se de forskjellige modellene.

Llama 3.1 er tilgjengelig i følgende tre parametere:

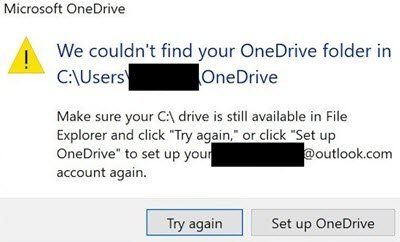

last ned skydrive for windows

- 8B

- 70B

- 405B

Den siste er den største parameteren og kan åpenbart ikke kjøres på en low-end PC. Llama 3.2 har følgende to parametere:

- 1B

- 3B

Klikk på Llama-versjonen du vil installere på PC-en. For eksempel, hvis du vil installere Llama 3.2, klikk på Llama 3.2. I rullegardinmenyen kan du velge parameteren du vil installere. Etter det kopierer du kommandoen ved siden av den og limer den inn i ledeteksten.

For enkelhets skyld har jeg skrevet begge kommandoene for Llama 3.2-modellen. For å installere Llama 3.2 3B-modellen, kjør følgende kommando:

ollama run llama3.2:3b

For å installere Llama 3.2 1B-modellen, bruk følgende kommando:

ollama run llama3.2:1b

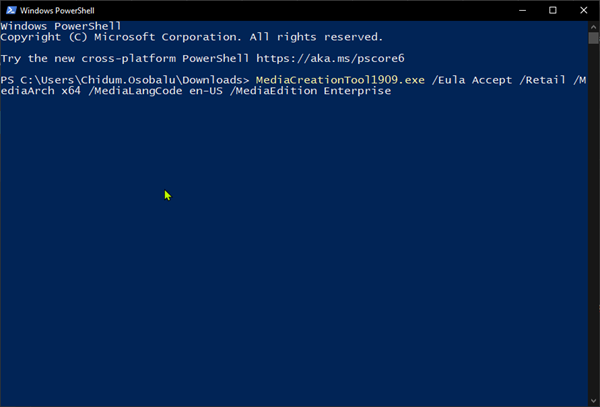

Åpne ledeteksten, skriv inn en av de ovennevnte kommandoene (basert på dine krav), og trykk Gå . Det vil ta litt tid å laste ned de nødvendige filene. Nedlastingstiden vil også avhenge av hastigheten på Internett-tilkoblingen din. Etter fullføringen vil du se suksess melding i ledeteksten.

Skriv inn meldingen din for å bruke Llama 3.2-modellen. Hvis du vil installere Llama 3.1-modellen, bruk kommandoene som er tilgjengelige på Ollama-nettstedet.

Neste gang du starter ledeteksten, bruk den samme kommandoen til å kjøre Llama 3.1 eller 3.2 på PC-en.

Å installere Llama 3 gjennom CMD har én ulempe. Den lagrer ikke chatteloggen din. Imidlertid, hvis du distribuerer den på den lokale verten, vil chatloggen din lagres og du vil få et bedre brukergrensesnitt. Den neste metoden viser hvordan du gjør det.

Distribuer Llama 3 Web UI på Windows 11

Å bruke Llama 3 i en nettleser gir et bedre brukergrensesnitt og lagrer også chatteloggen sammenlignet med å bruke den i CMD-vinduet. Jeg vil vise deg hvordan du distribuerer Llama 3 på nettleseren din.

For å bruke Llama 3 i nettleseren din, bør Llama 3 gjennom Ollama og Docker være installert på systemet ditt. Hvis du ikke har installert Llama 3 ennå, installer den med Ollama (som forklart ovenfor). Nå, last ned og installer Docker fra sin offisiell nettside .

Etter å ha installert Docker, start den og registrer deg for å opprette en konto. Docker vil ikke kjøre før du registrerer deg. Etter at du har registrert deg, logger du på kontoen din på Docker-appen. Minimer Docker til systemstatusfeltet. Docker- og Ollama-apper skal kjøres i bakgrunnen. Ellers kan du ikke bruke Llama 3 i nettleseren din.

Nå åpner du ledeteksten, kopierer følgende kommando og lim den inn i ledeteksten:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Kommandoen ovenfor vil ta litt tid å laste ned de nødvendige ressursene. Ha derfor litt tålmodighet. Etter at kommandoen er fullført, åpner du Docker og velger Containere seksjon fra venstre side. Du vil se at en container opprettes automatisk med porten 3000:8080.

Klikk på porten 3000:8080. Dette vil åpne en ny fane i standard nettleser. Nå, registrer deg og logg på for å bruke Llama 3 i nettleseren din. Hvis du ser adressefeltet, vil du se lokal vert: 3000 der, noe som betyr at Llama 3 er vert lokalt på datamaskinen din. Du kan bruke den uten internettforbindelse.

Velg din Llama chat-modell fra rullegardinmenyen. Hvis du vil legge til flere chat-modeller av Llama 3, må du installere den via Ollama ved å bruke de nødvendige kommandoene. Etter det vil modellen automatisk være tilgjengelig i nettleseren din.

All chat-loggen din vil bli lagret og tilgjengelig på venstre side. Når du vil avslutte, logger du av økten i nettleseren. Deretter åpner du Docker-appen og klikker på Stoppe knappen for å stoppe Docker. Nå kan du lukke Docker.

Når du vil bruke Llama 3 i nettleseren din neste gang, start Ollama og Docker, vent noen minutter, og klikk deretter på porten i Docker-beholderen for å åpne den lokale vertsserveren i nettleseren din. Logg inn på kontoen din og begynn å bruke Llama 3.

Jeg håper dette hjelper.

Kan Llama 3 kjøres på Windows?

Avhengig av datamaskinens maskinvarekonfigurasjon, kan du kjøre Llama 3 på systemet ditt. 1B-modellen er den letteste. Du kan installere og kjøre det på systemet ditt gjennom ledeteksten.

Hvor mye RAM trenger jeg for Llama 3?

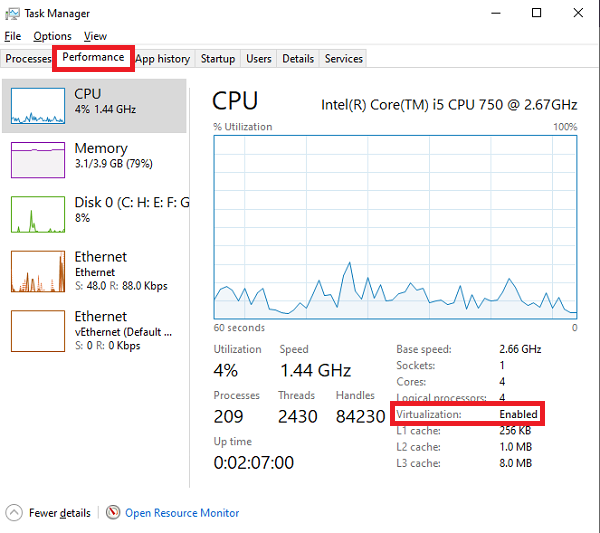

Den letteste modellen av Llama 3 er Llama 3.2 1B. Systemet ditt bør ha 16 GB RAM for å kjøre Llama 3.2 1B-modellen. I tillegg til dette bør systemet ditt også ha en kraftig GPU. De høyere modellene av Llama 3 krever flere systemressurser.

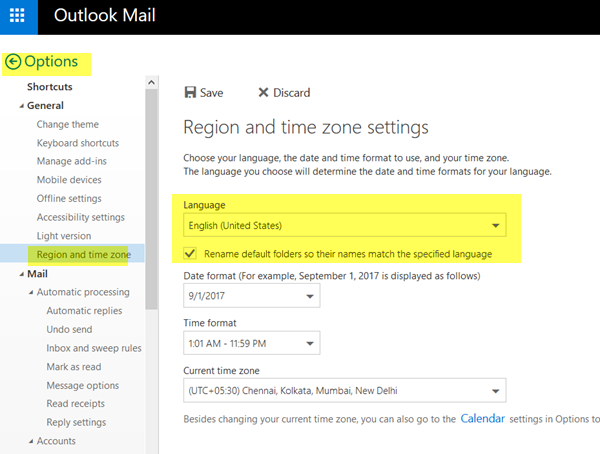

gratis bildesøm

Les neste : Slik bruker du Leonardo Phoenix AI .